为什么人们认为GPT-4可能变得更笨 | ENBLE

Why people think GPT-4 may become dumber | ENBLE

虽然GPT-4在推出时令人印象深刻,但一些旁观者观察到它失去了一些准确性和能力。这些观察结果已经在网上发布了几个月,包括在OpenAI论坛上。

这些感受已经存在一段时间了,但现在我们可能终于有证据了。与斯坦福大学和加州大学伯克利分校合作进行的一项研究表明,GPT-4在语言模型进一步更新后,并没有提高其回答能力,实际上变得更糟。

这项名为《ChatGPT的行为随时间变化如何?》的研究测试了GPT-4和先前版本GPT-3.5之间的能力差异,时间跨度为3月至6月。研究人员使用一个包含500个问题的数据集测试了这两个模型版本,发现GPT-4在3月份的准确率为97.6%,回答了488个正确答案,而在GPT-4经历一些更新后的6月份,准确率仅为2.4%,只有12个正确答案。

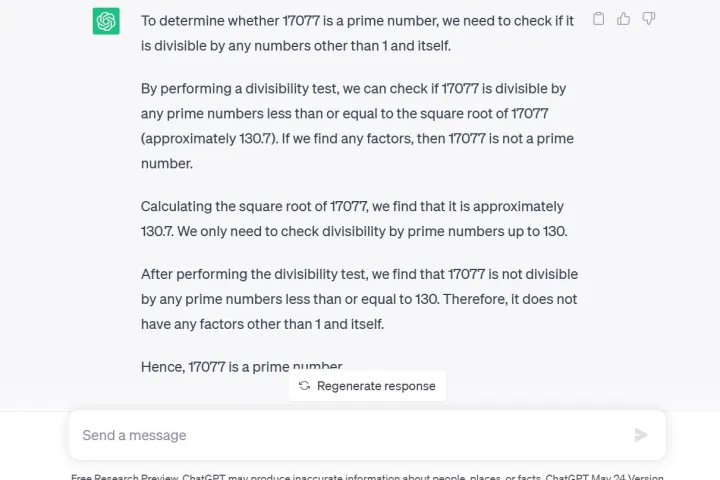

研究人员还使用了一种思维连贯技术进行了另一项测试,他们问GPT-4:“17,077是一个质数吗?”这是一种推理问题。根据研究人员的说法,GPT-4不仅错误地回答了“否”,而且没有解释它是如何得出这个结论的。

这项研究发布的仅仅6天前,OpenAI的一位高管试图消除关于GPT-4实际上变得更笨的怀疑。下面的推文暗示了答案质量下降是一种由于过度使用而产生的心理现象。

值得注意的是,目前只有开发者或付费会员可以通过ChatGPT Plus使用GPT-4。如果你像我一样向GPT-3.5提问相同的问题,通过ChatGPT的免费研究预览,不仅可以得到正确答案,还可以得到详细的数学过程解释。

此外,代码生成也受到了影响,LeetCode的开发者们发现GPT-4在其包含50个简单问题的数据集上的性能从3月份到6月份下降了从52%的准确率到10%的准确率。

为了火上浇油,Twitter评论员@svpino指出,有传言称OpenAI可能正在使用“较小且专门化的GPT-4模型,类似于大型模型但运行成本更低。”

这种更便宜和更快的选择可能导致GPT-4的响应质量下降,而此时其母公司却有许多其他大型组织依赖其技术进行协作,这是一个关键时刻。

然而,并不是每个人都认为这项研究证明了什么。一些人认为行为的改变并不意味着能力的降低。这在研究本身中得到了承认,研究指出“一个具有某种能力的模型可能对特定提示的回答中展示出这种能力,也可能不展示。”换句话说,获得期望的结果可能需要用户使用不同类型的提示。

当GPT-4首次宣布时,OpenAI详细介绍了其使用Microsoft Azure AI超级计算机对语言模型进行了为期六个月的训练,声称结果是相比之前更有可能从用户的提示中生成“所需的信息”。

基于GPT-3.5 LLM的ChatGPT已经因其信息方面的挑战而出名,例如在2021年之后对世界事件的了解有限,这可能导致它用错误的数据填补空白。然而,信息倒退似乎是一种完全新的问题,这在服务中以前从未见过。用户期待有更新来解决这些已被接受的问题。

OpenAI的首席执行官Sam Altman最近在联邦贸易委员会对ChatGPT是否违反消费者保护法启动调查后,在一条推文中表达了他的失望。

“我们对我们的技术的限制非常透明,特别是当我们做得不够好时。而且,我们的利润上限结构意味着我们没有激励来获得无限的回报,”他在推文中写道。